从Hugging Face下载模型。

git clone https://huggingface.co/THUDM/chatglm2-6b如果网络不是很好,可以只下载模型实现,然后再下载模型参数文件

GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/THUDM/chatglm-6b

## 模型文件

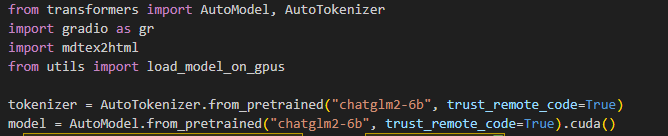

https://cloud.tsinghua.edu.cn/d/fb9f16d6dc8f482596c2/下载Demo文件,支持命令行、网页、例子。默认是自动下载模型实现和参数,如果已经安装上面步骤下好了模型,那你可以修改代码,将THUDM/chatglm2-6b修改为你的下载模型路径。使用openai版api需要安装pydantic 1.10依赖。

git clone https://github.com/THUDM/ChatGLM-6B

pip install -r requirements.txt

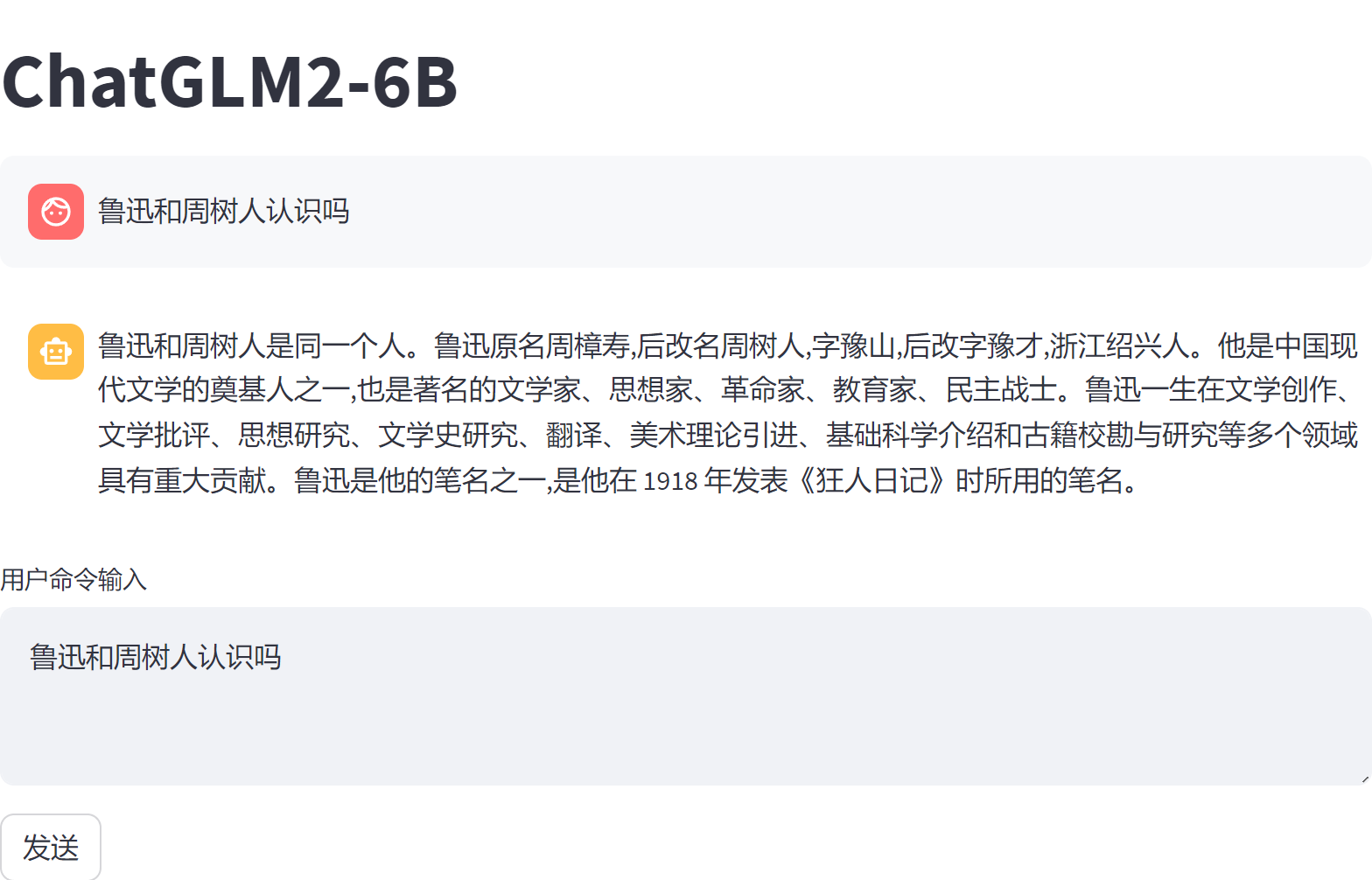

# 运行网页版

streamlit run web_demo2.py

# 运行API

python api.py

# 运行openai版API

python openai_api.py

总结

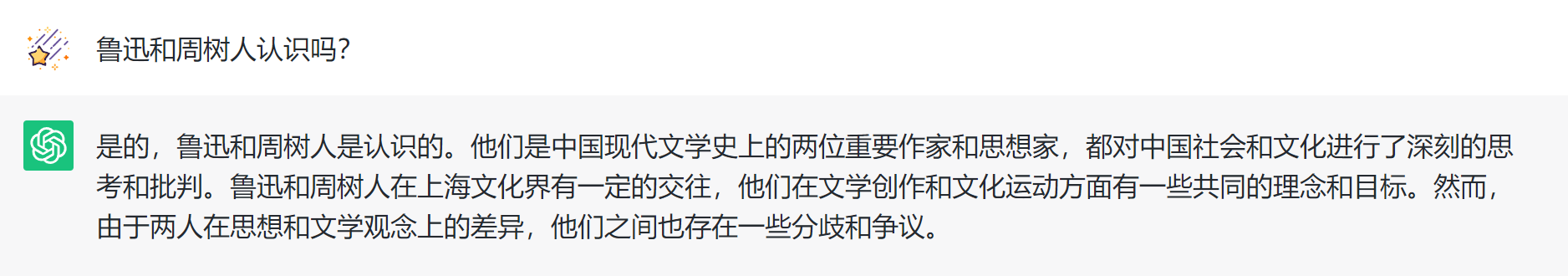

我的显卡性能比较弱,如果只有一个人使用,速度还可以,同时打开两个会话就很卡了。体验感觉和chatgpt差不多,问了个chatgpt胡言乱语的问题chatglm能答出来。但是有些问题又感觉没有Chatgpt回答得好

错误

1.出现CUDA错误

File "C:\Program Files\Python311\Lib\site-packages\torch\cuda\__init__.py", line 239, in _lazy_init

raise AssertionError("Torch not compiled with CUDA enabled")

AssertionError: Torch not compiled with CUDA enabled查看cuda版本,并重新安装支持cuda的torch。

pip uninstall torch

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

#https://stackoverflow.com/questions/75752503/error-torch-not-compiled-with-cuda-enabled本站文章除注明转载/出处外,均为本站原创或翻译,如若转载,请注明出处。